Google объявила о революционной технологии под названием CALM, которая ускоряет большие языковые модели (такие как GPT-3 и LaMDA) без ущерба для уровня производительности.

Большие обучающие данные лучше, но имеют свою цену

Модели больших языков (LLM) тренируются на больших объемах данных.

Обучение языковых моделей на больших объемах данных приводит к тому, что модель изучает новые возможности, которые не всегда запланированы.

Например, добавление дополнительных обучающих данных в языковую модель может неожиданно привести к тому, что она получит возможность переводить между разными языками, даже если она не была обучена этому.

Эти новые способности называются эмерджентными способностями, то есть способностями, которые не обязательно запланированы.

В другом исследовательском документе (PDF) о возникающих способностях говорится:

«Хотя существуют десятки примеров эмерджентных способностей, в настоящее время мало убедительных объяснений того, почему такие способности возникают именно так, как они это делают».

Они не могут объяснить, почему изучаются разные способности.

Но хорошо известно, что увеличение объема данных для обучения машины позволяет ей получить больше возможностей.

Недостатком масштабирования обучающих данных является то, что для получения вывода требуется больше вычислительной мощности, что делает ИИ медленнее в то время, когда он генерирует текстовый вывод (момент, который называется «время вывода»).

Таким образом, компромисс с тем, чтобы сделать ИИ умнее с большим количеством данных, заключается в том, что ИИ также становится медленнее во время вывода.

Новая исследовательская работа Google (Уверенное адаптивное языковое моделирование PDF) описывает проблему следующим образом:

«Недавние достижения в больших языковых моделях (LLM) на основе Transformer привели к значительному повышению производительности во многих задачах.

Эти преимущества связаны с резким увеличением размера моделей, что может привести к медленному и дорогостоящему использованию во время вывода».

Уверенное адаптивное языковое моделирование (CALM)

Исследователи из Google нашли интересное решение для ускорения языковых моделей при сохранении высокой производительности.

Решение, если провести аналогию, чем-то похоже на разницу между ответом на простой вопрос и решением более сложного.

На простой вопрос, например, какого цвета небо, можно ответить, не задумываясь.

Но трудный ответ требует, чтобы человек остановился и еще немного подумал, чтобы найти ответ.

С вычислительной точки зрения большие языковые модели не делают различия между сложной частью задачи генерации текста и легкой частью.

Они генерируют текст как для простых, так и для сложных частей, используя всю свою вычислительную мощность во время вывода.

Решение Google называется Уверенное адаптивное языковое моделирование (CALM).

Что делает эта новая структура, так это выделяет меньше ресурсов на тривиальные части задачи генерации текста и направляет всю мощность на более сложные части.

В исследовательской работе по CALM проблема и решение сформулированы следующим образом:

«Недавние достижения в больших языковых моделях (LLM) на основе Transformer привели к значительному повышению производительности во многих задачах.

Эти преимущества связаны с резким увеличением размера моделей, что может привести к медленному и дорогостоящему использованию во время вывода.

На практике, однако, серия поколений, созданных LLM, состоит из различных уровней сложности.

В то время как некоторые прогнозы действительно выигрывают от полной мощности моделей, другие продолжения более тривиальны и могут быть решены с меньшим объемом вычислений.

…Хотя большие модели в целом работают лучше, может не потребоваться одинаковый объем вычислений для каждого ввода для достижения одинаковой производительности (например, в зависимости от того, является ли ввод простым или сложным)».

Что такое Google CALM и работает ли он?

CALM работает путем динамического распределения ресурсов в зависимости от сложности отдельной части задачи, используя алгоритм для прогнозирования того, требуются ли для чего-либо полные или частичные ресурсы.

В исследовательской работе сообщается, что они протестировали новую систему для различных задач обработки естественного языка («обобщение текста, машинный перевод и ответы на вопросы») и обнаружили, что они смогли ускорить вывод примерно в три раза (300%). .

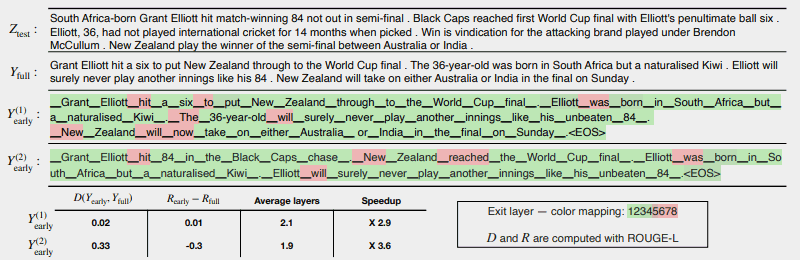

На следующем рисунке показано, насколько хорошо работает система CALM.

Несколько областей, выделенных красным цветом, указывают, где машина должна была использовать всю свою мощность в этом разделе задачи.

Области, выделенные зеленым цветом, — это места, где машина использовала менее половины мощности.

Красный = Полная емкость/Зеленый = Менее половины емкости

Вот что говорится в исследовательской работе об приведенной выше иллюстрации:

«CALM ускоряет генерацию за счет раннего выхода, когда это возможно, и выборочного использования полной мощности декодера только для нескольких токенов, что продемонстрировано здесь на примере CNN / DM с мерой достоверности на основе softmax. Y (1) раньше и Y (2) раньше используют разные доверительные пороги для досрочного выхода.

Ниже (sic) текста мы сообщаем об измеренной согласованности текстов и рисков каждого из двух выходных данных, а также о повышении эффективности.

Цвета представляют количество слоев декодирования, используемых для каждого маркера — светло-зеленые оттенки обозначают менее половины всех слоев.

Только несколько выбранных токенов используют полную мощность модели (обозначены красным), в то время как для большинства токенов модель выходит после одного или нескольких слоев декодирования (обозначены зеленым цветом)».

Исследователи завершили статью, отметив, что реализация CALM требует лишь минимальных модификаций, чтобы адаптировать большую языковую модель, чтобы она стала быстрее.

Это исследование важно, потому что оно открывает двери для создания более сложных моделей ИИ, которые обучаются на значительно больших наборах данных без снижения скорости при сохранении высокого уровня производительности.

Тем не менее, возможно, что этот метод также может принести пользу большим языковым моделям, которые также обучаются на меньшем количестве данных.

Например, модели InstructGPT, дочерней моделью которых является ChatGPT, обучаются примерно по 1,3 миллиардам параметров, но все же могут превосходить модели, обученные по значительно большему количеству параметров.

В заключении исследователи отметили:

«В целом, наша полная адаптивная вычислительная среда для LM требует минимальных модификаций базовой модели и обеспечивает повышение эффективности при соблюдении строгих гарантий качества на выходе».

Эта информация об этом исследовательском документе была только что опубликована в блоге Google AI 16 декабря 2022 года. Сама исследовательская статья датирована 25 октября 2022 года.

Будет интересно посмотреть, войдет ли эта технология в большие языковые модели ближайшего будущего.

Прочитайте сообщение в блоге Google:

Ускорение генерации текста с помощью уверенного адаптивного языкового моделирования (CALM)

Прочитайте исследовательскую работу:

Уверенное адаптивное языковое моделирование (PDF)

Избранное изображение Shutterstock/Master1305

Подборка статей по SEO оптимизации сайта. Выбора стратегии продвижения. Продвижение сайта в поисковых системах и социальных сетях. Обучение востребованным профессиям в сфере IT. Настройка рекламных кампаний в интернет. Маркетинг. Анализ рынка. Полезные секреты проведения рекламных кампаний. Все для PR — менеджера.

Специальная подборка для Вас