Поисковая оптимизация, в самом общем смысле, полагается прежде всего на одну вещь: роботы поисковых систем сканируют и индексируют ваш сайт.

Но почти на каждом веб-сайте есть страницы, которые вы не хотите включать в это исследование.

Например, вы действительно хотите, чтобы ваша политика конфиденциальности или страницы внутреннего поиска отображались в результатах Google?

В лучшем случае они ничего не делают для активного привлечения трафика на ваш сайт, а в худшем случае могут отвлекать трафик от более важных страниц.

К счастью, Google позволяет веб-мастерам указывать роботам поисковых систем, какие страницы и контент сканировать, а какие игнорировать. Есть несколько способов сделать это, наиболее распространенным является использование файла robots.txt или метатега robots.

У нас есть отличное и подробное объяснение всех тонкостей robots.txt, которое вам обязательно нужно прочитать.

Но в терминах высокого уровня это обычный текстовый файл, который находится в корневом каталоге вашего веб-сайта и соответствует протоколу исключения роботов (REP).

Robots.txt предоставляет сканерам инструкции по сайту в целом, а метатеги robots содержат указания для конкретных страниц.

Некоторые метатеги robots, которые вы можете использовать, включают показателькоторый говорит поисковым системам добавить страницу в свой индекс; без индексакоторый говорит ему не добавлять страницу в индекс или включать ее в результаты поиска; следитькоторый указывает поисковой системе переходить по ссылкам на странице; не следуеткоторый говорит ему не переходить по ссылкам, и целый ряд других.

И robots.txt, и метатеги robots являются полезными инструментами, которые следует держать в своем наборе инструментов, но есть и другой способ указать ботам поисковых систем использовать noindex или nofollow: X-Robots-Tag.

Что такое тег X-Robots?

X-Robots-Tag — это еще один способ контролировать, как пауки сканируют и индексируют ваши веб-страницы. Как часть ответа HTTP-заголовка на URL-адрес, он управляет индексацией всей страницы, а также определенных элементов на этой странице.

И в то время как использование мета-тегов robots довольно просто, X-Robots-Tag немного сложнее.

Но тут, конечно, возникает вопрос:

Когда следует использовать X-Robots-Tag?

Согласно Google, «любая директива, которая может использоваться в метатеге robots, также может быть указана как X-Robots-Tag».

Хотя вы можете установить связанные с robots.txt директивы в заголовках HTTP-ответа как с метатегом robots, так и с тегом X-Robots, существуют определенные ситуации, когда вы хотели бы использовать X-Robots-Tag — два наиболее распространенных когда:

- Вы хотите контролировать, как ваши файлы, отличные от HTML, сканируются и индексируются.

- Вы хотите обслуживать директивы по всему сайту, а не на уровне страницы.

Например, если вы хотите заблокировать сканирование определенного изображения или видео, метод ответа HTTP упрощает эту задачу.

Заголовок X-Robots-Tag также полезен, поскольку позволяет комбинировать несколько тегов в ответе HTTP или использовать список директив, разделенных запятыми, для указания директив.

Возможно, вы не хотите, чтобы определенная страница кэшировалась, и хотите, чтобы она была недоступна после определенной даты. Вы можете использовать комбинацию тегов «noarchive» и «unavailable_after», чтобы проинструктировать роботов поисковых систем следовать этим инструкциям.

По сути, сила X-Robots-Tag заключается в том, что он гораздо более гибкий, чем метатег robots.

Преимущество использования X-Robots-Tag с HTTP-ответами заключается в том, что он позволяет вам использовать регулярные выражения для выполнения директив обхода не-HTML, а также применять параметры на более широком глобальном уровне.

Чтобы помочь вам понять разницу между этими директивами, полезно классифицировать их по типам. То есть это директивы сканера или директивы индексатора?

Вот удобная шпаргалка для объяснения:

| Директивы сканера | Директивы индексатора |

| Роботы.txt – использует директивы пользовательского агента, разрешать, запрещать и карты сайта, чтобы указать, где ботам поисковых систем на сайте разрешено сканировать и где запрещено сканировать. | Тег Мета Роботы — позволяет указать и запретить поисковым системам показывать определенные страницы сайта в результатах поиска. Не следует — позволяет указать ссылки, которые не должны проходить по авторитету или PageRank. X-Robots-тег – позволяет вам контролировать, как индексируются указанные типы файлов. |

Где вы размещаете X-Robots-Tag?

Допустим, вы хотите заблокировать определенные типы файлов. Идеальным подходом было бы добавление тега X-Robots-Tag в конфигурацию Apache или файл .htaccess.

X-Robots-Tag можно добавить к HTTP-ответам сайта в конфигурации сервера Apache через файл .htaccess.

Реальные примеры и использование X-Robots-Tag

Так что это звучит великолепно в теории, но как это выглядит в реальном мире? Давайте взглянем.

Допустим, мы хотели, чтобы поисковые системы не индексировали файлы .pdf. Эта конфигурация на серверах Apache будет выглядеть примерно так:

<Files ~ "\.pdf$"> Header set X-Robots-Tag "noindex, nofollow" </Files>

В Nginx это будет выглядеть так:

location ~* \.pdf$ {

add_header X-Robots-Tag "noindex, nofollow";

} Теперь давайте рассмотрим другой сценарий. Допустим, мы хотим использовать X-Robots-Tag для блокировки файлов изображений, таких как .jpg, .gif, .png и т. д., от индексации. Вы можете сделать это с помощью тега X-Robots-Tag, который будет выглядеть следующим образом:

<Files ~ "\.(png|jpe?g|gif)$"> Header set X-Robots-Tag "noindex" </Files>

Обратите внимание, что понимание того, как работают эти директивы и как они влияют друг на друга, имеет решающее значение.

Например, что произойдет, если и тег X-Robots-Tag, и метатег robots будут обнаружены, когда роботы-сканеры обнаружат URL-адрес?

Если этот URL-адрес заблокирован в файле robots.txt, то определенные директивы индексации и обслуживания не могут быть обнаружены и не будут соблюдаться.

Если директивы должны соблюдаться, URL-адреса, содержащие их, не могут быть запрещены для сканирования.

Проверить X-Robots-Tag

Есть несколько различных методов, которые можно использовать для проверки X-Robots-Tag на сайте.

Самый простой способ проверить — установить расширение для браузера, которое сообщит вам информацию X-Robots-Tag об URL-адресе.

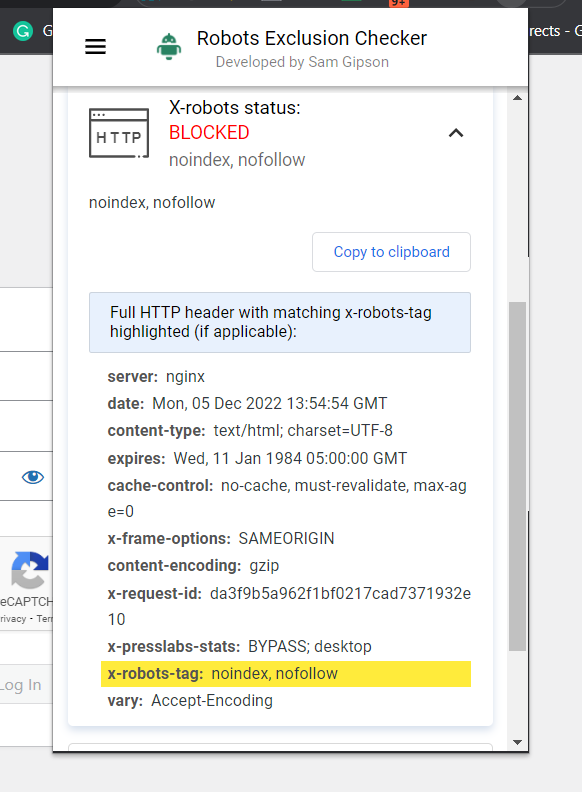

Скриншот средства проверки исключения роботов, декабрь 2022 г.

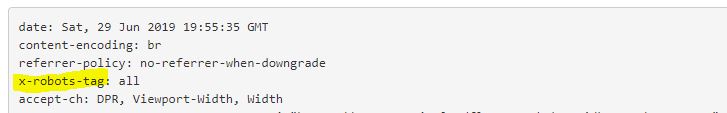

Скриншот средства проверки исключения роботов, декабрь 2022 г.Другой подключаемый модуль, который вы можете использовать, чтобы определить, например, используется ли X-Robots-Tag, — это подключаемый модуль веб-разработчика.

Нажав на плагин в вашем браузере и перейдя к «Просмотр заголовков ответа», вы можете увидеть различные используемые заголовки HTTP.

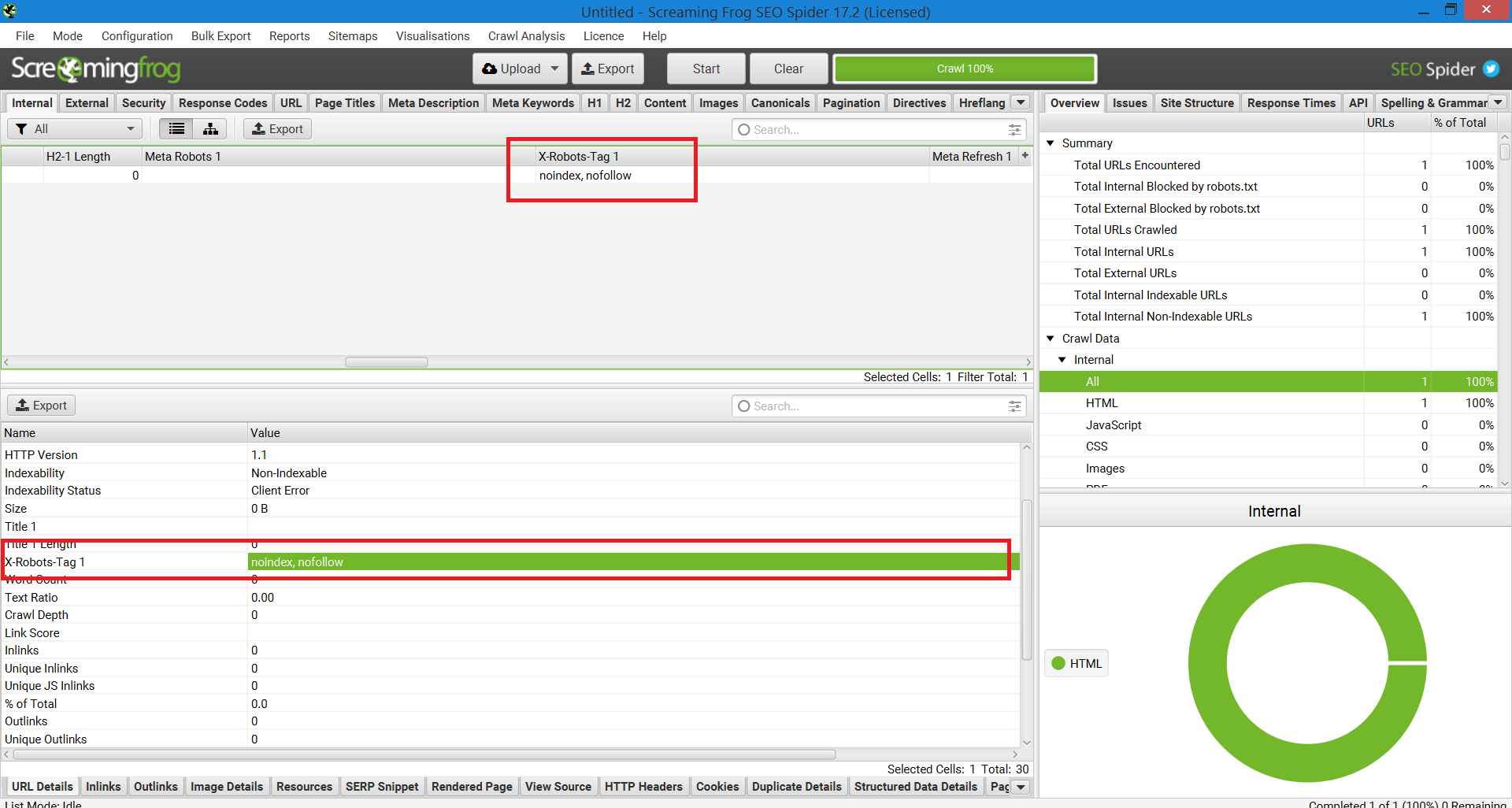

Еще один метод, который можно использовать для масштабирования, чтобы точно определить проблемы на веб-сайтах с миллионом страниц, — это Screaming Frog.

После запуска сайта через Screaming Frog вы можете перейти к столбцу «X-Robots-Tag».

Это покажет вам, какие разделы сайта используют тег, а также какие конкретные директивы.

Скриншот отчета Screaming Frog. X-Robot-Tag, декабрь 2022 г.

Скриншот отчета Screaming Frog. X-Robot-Tag, декабрь 2022 г.Использование тегов X-Robots на вашем сайте

Понимание и контроль того, как поисковые системы взаимодействуют с вашим сайтом, является краеугольным камнем поисковой оптимизации. И X-Robots-Tag — мощный инструмент, который вы можете использовать именно для этого.

Просто имейте в виду: это не без опасностей. Очень легко ошибиться и деиндексировать весь сайт.

Тем не менее, если вы читаете эту статью, вы, вероятно, не новичок в SEO. Пока вы используете его с умом, не торопитесь и проверяете свою работу, вы обнаружите, что X-Robots-Tag станет полезным дополнением к вашему арсеналу.

Дополнительные ресурсы:

Избранное изображение: Song_about_summer/Shutterstock

Подборка статей по SEO оптимизации сайта. Выбора стратегии продвижения. Продвижение сайта в поисковых системах и социальных сетях. Обучение востребованным профессиям в сфере IT. Настройка рекламных кампаний в интернет. Маркетинг. Анализ рынка. Полезные секреты проведения рекламных кампаний. Все для PR — менеджера.

Специальная подборка для Вас